今儿个,咱来聊聊我咋折腾弹性负载均衡的。我就是个愣头青,就知道这玩意儿能把流量分给不同的服务器,听起来挺高大上的,具体咋回事儿,两眼一抹黑。

摸索阶段

我就是瞎捣鼓。我记得我先找几台破电脑,装上不同的操作系统,有Windows的,也有Linux的。然后就开始在网上找资料,看看人家都是咋弄的。看半天,发现大家伙儿用的比较多的就是那几个软件,像什么LVS、Nginx、HAProxy,看得我头都大。 我就想:“这都啥玩意儿,咋这么复杂?”

实践出真知

后来我就想,光看可不行,得动手试试。于是我先挑个看起来比较顺眼的Nginx,照着网上的教程一步一步来。装软件、改配置,还真别说,一步步跟着做下来,还真有点儿意思。

我就简单地配置一下,把请求轮流发给那几台服务器。弄完之后,我用浏览器访问一下,还真能用!不同的页面在几台服务器之间跳来跳去,看着就觉得神奇。不过这只是最基本的,离“弹性”还差得远。

然后,我就开始琢磨,咋才能让它“弹性”起来?这“弹性”说白,不就是能根据服务器的忙闲程度,自动调整流量分配嘛我又开始翻资料,发现Nginx有个叫“upstream”的模块,里边可以配置不同的策略,比如根据服务器的权重、响应时间啥的来分配流量。

我试着改改配置,把几台服务器的权重设成不一样的,然后用压测工具模拟一堆请求,再去看Nginx的日志。还真像那么回事儿!权重高的服务器,处理的请求就多,权重低的就少。我又试着把一台服务器搞“挂掉”,Nginx也能自动把流量分给其他服务器,保证服务还能用。

进阶之路

折腾完Nginx,我又试试LVS和HAProxy。LVS这家伙,据说性能特别强,能扛住很大的流量。我找个Linux系统,装上ipvsadm,对着文档一点点配置。这玩意儿比Nginx复杂多,配置起来也更麻烦,不过弄明白之后,感觉还挺有成就感的。

HAProxy,我觉得它比较适合做应用层的负载均衡。它能根据HTTP请求头、URL啥的来做更细致的流量控制,还能搞SSL加密啥的。我试着配置一下,把不同的请求转发到不同的后端服务器,也挺好玩的。

最终实现

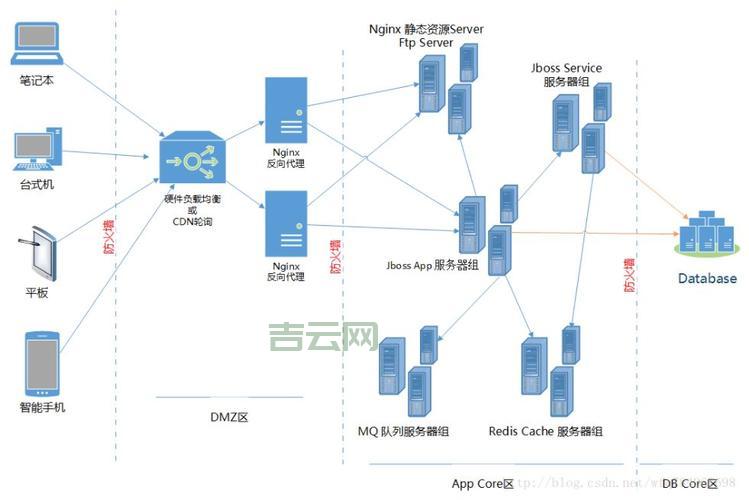

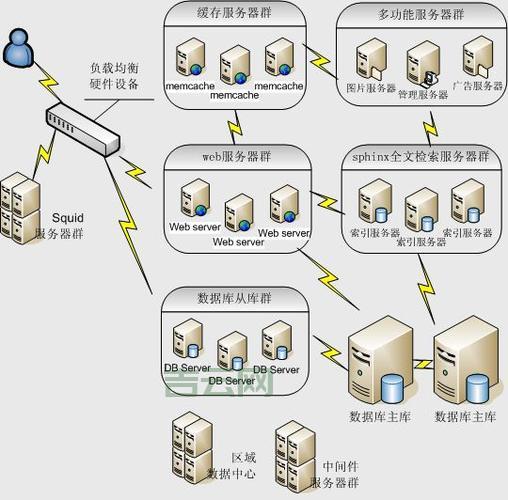

经过一番折腾,我现在对弹性负载均衡也算有点儿心得。我觉得这玩意儿,就是个“交警”,负责把“车流”(请求)引导到不同的“车道”(服务器)上。关键是要选好“交警”(负载均衡器),然后根据实际情况,配置好“交通规则”(策略)。

我把这套东西用在我自己的网站上,再也不怕突然来一大波流量把服务器搞垮。而且我还琢磨着,以后可以把这套东西跟云计算平台结合起来,实现真正的“弹性伸缩”,那就更爽!

实践出真知,多动手,多折腾,才能真正掌握这些技术。